当全球科技巨头仍在为下一代GPU争夺产能、不断扩建耗电量堪比小镇的数据中心时,一场静默却深远的技术转向正在中国浮现。由中国科学院自动化研究所研发的SpikingBrain 1.0,不仅是又一个大型语言模型的发布,更是一次对当前主流AI范式的系统性质疑——它用“类脑”的脉冲计算机制,在不依赖英伟达芯片的前提下,实现了在特定任务上高达100倍的速度跃升。这一现象背后,折射出的是一场关于效率、自主与未来计算经济性的深层变革。

表面上看,这是一次算法创新。SpikingBrain 1.0的核心突破在于采用了“脉冲神经网络”(SNN)架构,模拟人脑仅在必要时才激发神经元的机制。与传统大模型无论输入多短都激活全部参数不同,该系统采用事件驱动模式,大部分时间处于低功耗静默状态,只在接收到信号时触发局部响应。这种设计直接降低了运行时的能耗和延迟,尤其在处理长序列数据时优势显著。测试显示,面对400万个令牌的输入,其响应速度较标准系统快逾百倍。这并非简单的性能优化,而是对AI“暴力计算”逻辑的根本性重构。

然而,若仅将其视为一次技术迭代,则可能低估其战略意义。真正关键的突破,在于这套系统完全构建于中国自主研发的AI生态之上。从底层硬件到模型架构,均未使用英伟达GPU,而是在上海企业MetaX集成电路有限公司开发的MetaX芯片平台上完成训练与部署。这意味着,中国首次实现了从芯片、计算框架到大模型的全栈式非西方技术路径闭环。在全球半导体供应链持续受地缘政治扰动的背景下,这种自主可控的能力已不再仅仅是技术选项,而成为关乎产业安全的基础设施。

进一步拆解其经济逻辑,SpikingBrain所代表的路径直指当前AI商业化的核心痛点——高昂的运营成本。目前主流生成式AI模型不仅训练过程耗资巨大,其推理阶段的资源消耗同样惊人。每一次用户提问,系统都要调动数十亿乃至千亿参数进行并行计算,导致服务器负载高、响应慢、电费攀升。据行业估算,头部AI公司的月度云服务支出已达数亿美元量级。而SpikingBrain仅需不到传统系统2%的训练数据,且运行中按需激活神经元,大幅降低内存占用与电力需求。这种效率提升,若能规模化落地,将显著改变AI服务的成本结构,使更多中小企业得以负担高级智能应用。

更深层次来看,这一进展揭示了AI发展路径的分化趋势。西方主导的路线仍以“规模取胜”:更大参数、更强算力、更多数据,形成高门槛的技术护城河。而中国正逐步探索“效率优先”的替代方案。通过类脑计算、稀疏化模型、专用芯片等手段,在有限资源下实现高性能输出。这种差异不仅是技术选择的结果,更是外部环境倒逼下的战略调整。在美国持续收紧对华先进芯片出口的背景下,无法获得顶级GPU的现实迫使本土研究机构跳出原有框架,寻找非对称突破点。

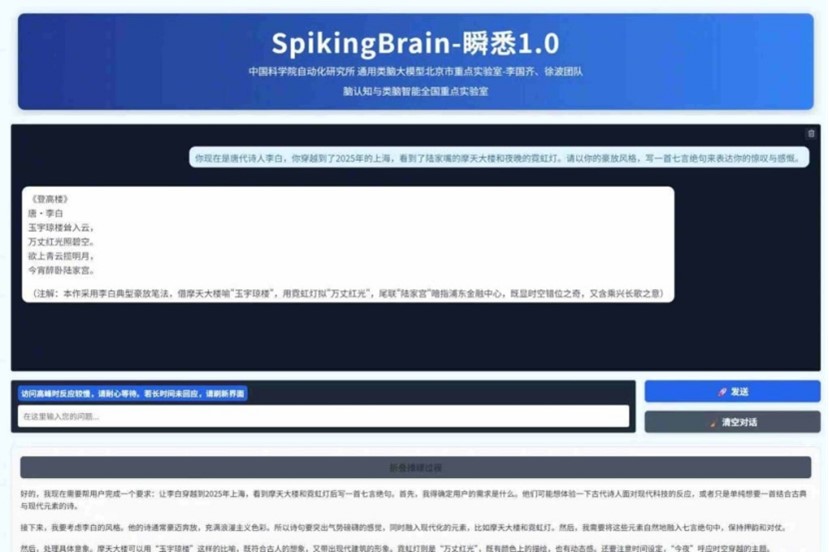

值得注意的是,SpikingBrain的成功并非孤立事件。它建立在近年来中国在脉冲神经网络、存算一体架构、国产AI芯片等领域持续投入的基础之上。此次70亿和760亿参数两个版本的模型均能在数百块国产芯片上稳定运行数周,证明了该技术具备初步工程化能力。研究团队已开源小模型并开放大模型测试,显示出推动生态建设的意图。一旦形成开发者社区和应用场景反馈闭环,这类高效架构有望在特定垂直领域率先落地,如法律文书分析、医疗文本处理或工业仿真等长上下文任务场景。

当然,挑战依然存在。脉冲神经网络的训练方法尚不成熟,兼容现有AI工具链的程度有限,且在通用能力上是否能全面匹敌Transformer架构仍有待验证。此外,MetaX平台的产能、良率及生态扩展能力也将决定该技术能否走出实验室。但不可否认的是,SpikingBrain提供了一个清晰信号:未来的AI竞争,或将不再单一取决于谁拥有最多的H100芯片,而更多体现在谁能以更低的成本、更高的效率完成实际任务。

从财经视角审视,这预示着AI投资逻辑的潜在转变。资本的关注点可能逐步从“算力囤积”转向“能效比优化”,从硬件采购转向软硬协同设计。那些能够实现单位算力更高产出的企业,将在长期运营中占据成本优势。同时,国产替代不再局限于“国产化率”指标,而是开始具备真正的性能竞争力。这为本土芯片、服务器、云计算厂商打开了新的市场空间。

长远而言,SpikingBrain的意义或许不在于立即颠覆现有格局,而在于证明了一条可行的差异化路径。在全球AI军备竞赛趋于白热化的今天,效率与自主正成为与性能同等重要的战略维度。中国正试图通过架构创新,将外部封锁的压力转化为技术跃迁的动力。这场始于实验室的变革,终将影响整个智能时代的产业版图与经济规则。