字节跳动Seed团队近日推出的GR-3大模型,正试图为机器人装上真正理解物理世界的“大脑”。这款40亿参数的Vision-Language-Action(VLA)模型,或将终结传统机器人“手脑割裂”的困境。

GR-3的核心突破在于其独特的Mixture-of-Transformers(MoT)架构,它将视觉语言理解与动作生成紧密耦合。这意味着机器人能直接依据摄像头画面与人类语言指令,实时生成动作序列。

一句“收拾餐桌”,即可触发打包剩菜、整理餐具、倾倒垃圾等一系列连贯操作。这种端到端的能力,显著缩短了从“理解”到“执行”的决策链条,为复杂任务自动化提供了全新范式。

训练数据的创新组合是GR-3泛化能力的基石。它突破了对单一机器人轨迹数据的依赖,开创性地融合三类数据源:遥操作机器人数据赋予其基础操作的稳定性;人类VR轨迹数据以近乎翻倍的效率教会它新技能;海量开放图文数据则大幅拓展其认知边界,使其能辨识新物体、理解抽象概念。这种复合训练范式,解决了机器人领域长期存在的数据稀缺与成本高昂难题。

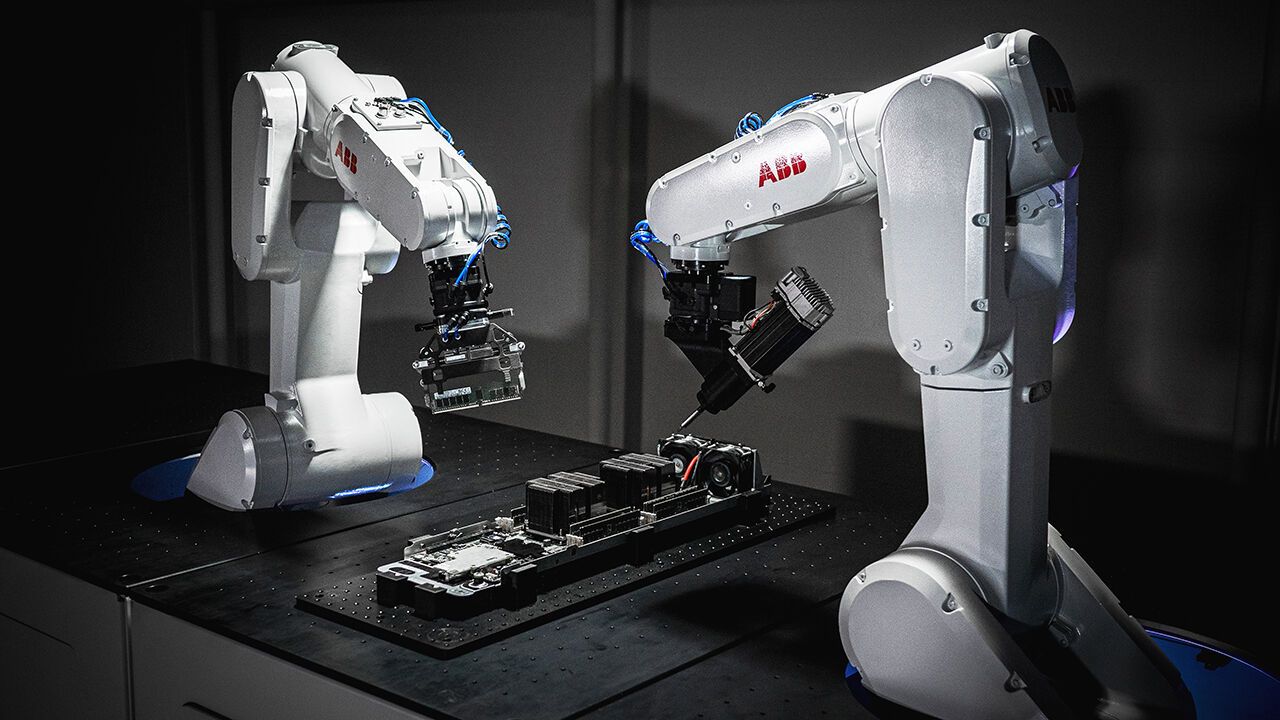

为匹配这颗强大“大脑”,字节同步推出通用双臂机器人ByteMini。其拥有22个全身自由度与独特的手腕球形关节设计,在狭小空间内仍能灵活完成精细操作。

搭载全身运动控制系统,动作兼具迅捷与柔顺,抓取纸杯等脆弱物也能精准控力。多摄像头协同布局,确保全局观察与细节捕捉无死角。

在实际测试中,GR-3展现出惊人适应力:面对陌生的卧室书桌或超市货架,其拾取放置任务的指令遵循率与成功率未见衰减;一句“收拾餐桌”指令,即可驱动系统自主完成全流程,平均完成度超95%;甚至在挂放不同款式柔性衣物这类高难度任务中,也保持稳定表现。

技术进化的脚步并未停歇。Seed团队计划扩大模型规模与数据量,并引入强化学习机制,推动GR-3突破模仿学习的局限,使其能在真实物理交互中通过“试错”自主优化策略——例如物体滑落后的快速应对。这标志着机器人学习正从被动模仿迈向自主进化。

GR-3的诞生,不仅是一个模型的迭代,更是机器人从感知智能迈向行动智能的关键一跃。当机器真正学会观察、思考并自主执行,一场重塑生产力图景的通用机器人革命,或许已悄然拉开序幕。